“悉灵杯”3D课题研究活动成果

39篇

- 使用3D相机MV-EB435i基于OpenCV的客流检测与异常识别的实现

- 悉灵杯”课题研究进展(一)通过海康RGB-D相机获取带RGB信息的点云

- “悉灵杯”课题研究-基于RGB_D相机的物品位置计算

- “悉灵杯”课题研究-对RGB_D相机采集的三维点云处理

- “悉灵杯”课题研究-RGB_D相机SDK集成及Open3d点云基本处理

- “悉灵杯”课题研究-集成RGB_D相机SDK的Open3d点云可视化

- “悉灵杯”课题研究-集成RGB_D相机SDK的Open3d点云功能UI项目开发(项目demo)

- “悉灵杯”课题研究-RGB_D相机SDK三维点云存储

- “悉灵杯”课题研究-OpenNI集成及示例代码开发

- 悉灵杯”课题研究-MV-EB435i立体相机基于opencv图像处理使用yolov5的物体识别

- “悉灵杯”课题研究-基于opecv的集成RGB_D相机SDK的基础小样物品颜色检测及人脸识别

- OpenCV中利用knn进行数字(0-9)识别--RGB-D相机采集

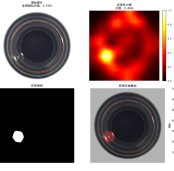

- “悉灵杯”课题研究-基于MV-EB435i的落差边缘检测算法开发记录

- 悉灵杯”课题研究-LabVIEW集成及示例代码开发

- “悉灵杯”课题研究-MV-EB435i立体相机集成Apriltags发布相机位姿

- “悉灵杯”课题研究-MV-EB435i立体相机图像处理UI界面开发

- “悉灵杯”课题研究-基于ROS1的RGB-D相机SDK集成及示例代码开发

- 第二届“悉灵杯”课题移动机器人感知研究进展

- “悉灵杯”课题研究—手眼标定方案

- 第二届“悉灵杯”课题研究-基于RGB_D相机的室内环境建模

- 悉灵杯”课题研究进展(二)-基于三维模型/场景点云的虚拟仿真数据生成

- 悉灵杯”课题研究进展(一)-实例分割网络模型搭建与实验场景介绍

- “悉灵杯”课题研究报告-基于RGB-D相机的2D和3D抓取定位方案研究

- “悉灵杯”课题研究-基于点云配准算法GICP的3D抓取方案研究

- “悉灵杯”课题研究-基于YOLO和GGCNN的物品平面抓取方案研究

- 动态手势控制音频播放器-成果物

- 第二届“悉灵杯”课题研究报告-动态手势控制音频播放器设计

- 动态手势控制音频播放器(五)动态手势控制音频播放器exe

- 动态手势控制音频播放器(四)动态手势识别系统的设计

- 动态手势控制音频播放器(三)音频播放器设计

- 动态手势控制音频播放器(二)动态手势识别系统的设计

- 动态手势控制音频播放器(一)总体方案设计

- 悉灵杯”课题研究进展(四)RGB-D相机引导机械臂分拣物料

- 悉灵杯”课题研究进展(三)RGB-D相机引导机械臂分拣物料

- 悉灵杯”课题研究进展(二)RGB-D相机引导机械臂分拣物料

- ”悉灵杯”课题研究报告-基于RGB-D相机的机械臂物料分拣系统研究

- 悉灵杯”课题研究报告-基于深度学习方法和虚拟仿真数据的机械臂引导方案

- 第二届“悉灵杯”课题研究机械臂引导研究报告

- 第二届“悉灵杯”课题研究机械臂引导研究进展(二)

- 第二届“悉灵杯”课题研究机械臂引导研究进展(一)

浙公网安备 33010802013223号

浙公网安备 33010802013223号